Noticias

Guía Sonido para UHD y 4K 709 MediaRoom, parte 1

Sonido para UHD y 4K

El sonido es una pieza fundamental para la mejorar de la experiencia de usuario ante los contenidos audiovisuales. Hemos entrevistado a Sergio Márquez, de Nómada Media, que generosamente ha compartido con nosotros sus conocimientos y nos ha ayudado a plasmar en esta sección las claves para el registro, postproducción y difusión del sonido para cine y el vídeo de ultra alta definición.

El sonido es una pieza fundamental para la mejorar de la experiencia de usuario ante los contenidos audiovisuales. Hemos entrevistado a Sergio Márquez, de Nómada Media, que generosamente ha compartido con nosotros sus conocimientos y nos ha ayudado a plasmar en esta sección las claves para el registro, postproducción y difusión del sonido para cine y el vídeo de ultra alta definición.

Vamos a comenzar describiendo los parámetros de calidad del sonido digital: frecuencia de muestreo (Sample Rate) y profundidad de bits (Bit Depth). A continuación, abordamos una cuestión fundamental: la sonoridad (loudness) que nos acerca a conceptos como el rango dinámico del sonido y la compresión dinámica.

Una vez expuestas estas bases teóricas repasaremos los distintos códecs para sonido envolvente que se están utilizando o desarrollando para el cine 4K y el vídeo de ultra alta definición. Lo hemos organizado en cinco apartados:

- Los inicios del audio digital para cine

- Sonido inmersivo, sonido 3D o sonido basado en objetos

- Sonido para salas de exhibición de cine

- Códecs Sonido para televisión en UHD y Blu-ray

- Códecs de sonido para difusión por internet

Frecuencia de muestreo (Sample Rate) y profundidad de bits (Bit Depth)

Los dos parámetros técnicos que definen la calidad de una señal digital de sonido son la frecuencia de muestreo y la profundidad de bits.

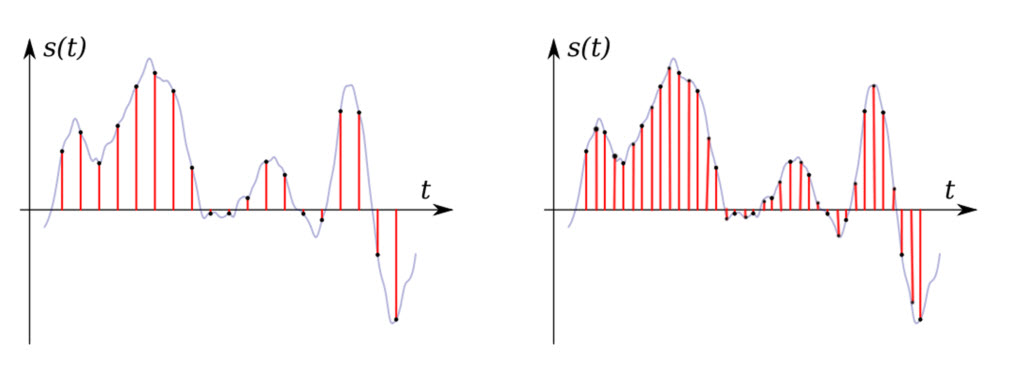

La frecuencia de muestreo (Sample Rate) es el número de muestras que se toman por segundo para generar la señal digital. Se expresa con un valor de ciclos por segundo en kilohercios (kHz).

Representación de dos valores distintos de frecuencia de muestreo. El eje horizontal representa el tiempo y el vertical el valor de la señal de audio. Fuente: Progulator.

La frecuencia de muestreo que se utiliza para registrar y procesar el sonido viene determinada por la capacidad sensorial de los seres humanos: se considera que podemos escuchar los sonidos que se sitúan entre 20 y 20.000 Hz. Según el teorema de Nyquist, es necesario que la frecuencia de muestreo sea superior al doble de la máxima frecuencia a muestrear. Por lo tanto, la frecuencia de muestreo ha de ser como mínimo de 40 KHz.

Los valores de frecuencia de muestreo que se utilizan habitualmente para sonido profesional son las siguientes:

| Frecuencia de muestreo | ||

| Audio CD | 44,1 kHz | |

| Broadcast / DVD | 48 kHz | |

| DVD Audio / Blu-ray | 96 kHz | |

| Blu-ray | 192 kHz | |

En producción musical para CD se ha utilizado tradicionalmente 44,1 kHz por la limitación de la capacidad de almacenamiento del soporte. Pero en producción audiovisual se considera insuficiente este valor de frecuencia de muestreo.

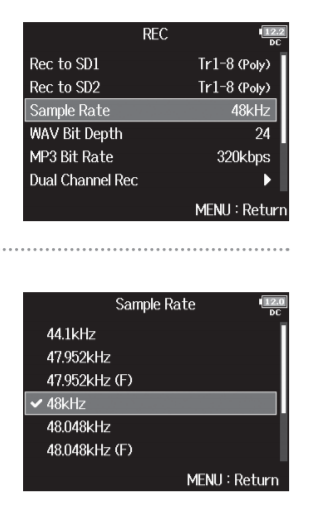

El estándar en producción audiovisual es 48 kHz. Las cámaras y los grabadores, desde la gama usuario hasta el nivel más profesional, utilizan esta frecuencia de muestreo. Es también el estándar para la difusión televisiva (broadcast) y para los discos DVD o Blu-ray. Igualmente, en captación de sonido directo, lo habitual es utilizar 48 kHz.

Menú de selección de la frecuencia de muestro de un grabador portátil de audio: Fuente: Zoom

En los estudios grabación y postproducción para audiovisual y cine de alta calidad, la tendencia es trabajar a 96 kHz. Aunque el material de sonido directo esté grabado a 48 kHz, el técnico hace la postproducción y la mezcla (reverbs, delays…) a 96 kHz. Este sobremuestreo aporta una serie de ventajas (mayor capacidad de alteración de un sonido original etc.) y permite dejar hasta el último momento la máxima calidad posible.

También en captación es cada vez más frecuente la grabación a 96 KHz, en tanto que los armónicos (múltiplos enteros que acompañan a cualquier frecuencia) son muy importantes para percibir con mayor naturalidad un sonido. Sobre todo, es fundamental el primer armónico (x2). Por ejemplo, cuando un violín emite una nota base de 15 kHz, su primer armónico es 30 kHz, y por lo tanto necesitamos 60 KHz de frecuencia de muestreo para poder capturarlo y reproducirlo. Por eso tiene sentido trabajar en un sistema completo de 96 KHz.

Las frecuencias de muestreo superiores, como 192 kHz, se utilizan en niveles ‘audiófilos’, en colecciones o sellos elitistas, como por ejemplo algunas grabaciones de música clásica de Deutsche Grammophon o en Jazz, las producciones de Chesky Records. Estas producciones intentan alcanzar la máxima calidad de sonido posible. Pero a nivel perceptivo, la mayoría de las personas no llegan a escuchar esta diferencia. En teoría por lo menos, una frecuencia de muestro de 48 kHz, es suficiente para registrar eficazmente la capacidad auditiva del ser humano.

La profundidad de bits (Bit Depth o cuantificación) es el número de bits que se utilizan para registrar cada una de las muestras. Cuantos más bits se utilicen, más información queda registrada y el archivo resultante ocupará más espacio en el soporte de la grabación. Por lo tanto, tiene que ver con la precisión de la muestra de audio que se cuantifica y con cuanta información se define.

Los valores que se utilizan habitualmente en audio profesional son los siguientes:

| Profundidad de bits (cuantificación) | ||

| Audio CD | 16 bits | |

| Broadcast / DVD / Blu-ray | 16 bits | |

| Sonido de alta calidad | 24 bits | |

| Máxima calidad | 32 bits | |

| Postproducción máxima calidad | 32 bit float | |

En captación de sonido directo casi todo se hace en 24 bits, aunque queda una herencia, todavía fuerte, de 16 bits. Los equipos ya están preparados desde hace años para 24 bits y pueden grabar sin problemas a 32 bits.

La profundidad de bits está íntimamente relacionada con el rango dinámico de audio. Es decir, con la capacidad de registrar con calidad los sonidos más leves y los de nivel más alto. La percepción humana del sonido se estima en 120 decibelios de rango dinámico y con 24 bits es más que suficiente para registrar estos valores.

En postproducción se puede hacer todo a 32 bits, a 32 bits coma flotante (float) e incluso algunas tarjetas gráficas a valores superiores. Pero lo más habitual es trabajar a 24 bits.

La representación en coma flotante (en inglés floating point) indica que para los cálculos que realiza el equipo, se van a utilizar tantos decimales como sea necesario para garantizar la preservación de la calidad original. En los equipos de postproducción de alta calidad se puede elegir esta opción.

Estas dos variables, frecuencia de muestreo y profundidad de bits, dan como resultado un flujo de transferencia (BitRate) que se mide en bits por segundo (b/s, Kb/s o Mb/s).

Los valores de flujo de transferencia con los se suele trabajar en las distintas fases de la producción y difusión de sonido son los siguientes:

| Flujo de transferencia | ||

| Sonido mono comprimido MP3 (calidad insuficiente) | 64 Kb/s | |

| Audio estéreo con compresión AAC (calidad suficiente) | 256 Kb/s | |

| Dolby Digital 5.1 en DVD | 448 Kb/s | |

| Audio estéreo PCM sin compresión (16bits; 48khz) | 1,5 Mb/s | |

| Audio 5.1 PCM sin compresión (24bits; 48khz) | 7 Mb/s | |

| DTS HD Master Audio 7.1 (24bits; 96 khz) | 24 Mb/s | |

Compresión dinámica / compresión de datos

En sonido digital la palabra “compresión” se utiliza en dos contextos diferentes con significados muy distintos:

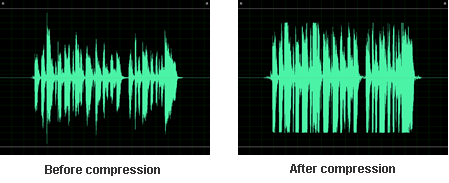

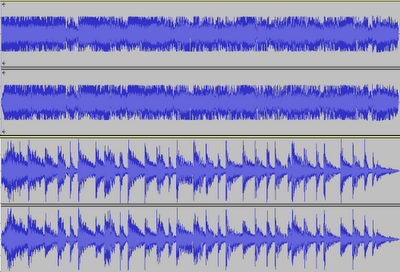

- Compresión dinámica. En postproducción de sonido, la compresión es una manipulación de los niveles dinámicos de la señal que tiene como objetivo reforzar los sonidos más débiles y atenuar los más altos. Se utilizan los compresores dinámicos típicamente en radiodifusión y en música popular para aumentar la sonoridad. Las producciones de sonido de alta calidad evitan el uso de compresores en favor del rango dinámico.

Compresión dinámica de una señal de audio. fuente:Articulate

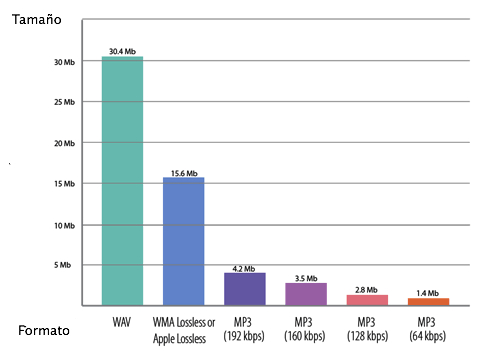

- Compresión de datos. Cuando se hace la codificación digital del sonido, la compresión es la reducción del tamaño de los archivos mediante unos algoritmos que llamamos ‘códecs de audio’. El ejemplo más conocido de compresión de datos para sonido es el formato ‘.mp3’, que reduce drásticamente el espacio que ocupa un archivo de audio en un disco duro, a costa de una pérdida de información y por lo tanto de la calidad. En difusión de sonido para cine la norma de compresión más extendida es ‘Dolby Digital’.

Compresión de datos MP3. fuente: Sarte Audio Elite

Compresión de datos en los formatos de máxima calidad. Fuente: The Media Server

Rango dinámico y sonoridad

El rango dinámico del sonido es la diferencia entre los valores de nivel más bajos y los más altos. Se mide en decibelios (db).

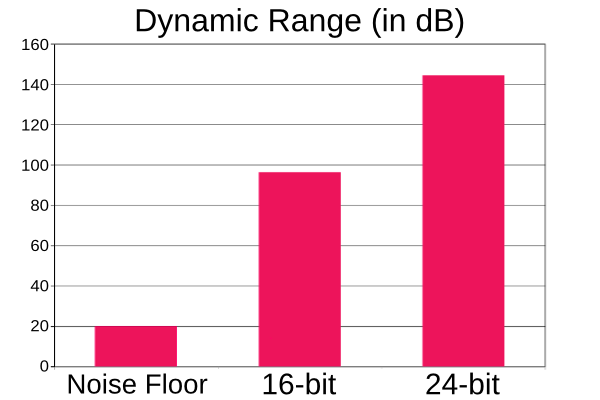

Existe una relación directa entre profundidad de bits y rango dinámico del sonido: cada bit que se emplea para generar la señal digital incrementa en 6 db la capacidad de registro de presión sonora. Con 16 bits se alcanzan 96 db de rango dinámico y se amplía a 144 db para 24 bits. Este valor de rango dinámico es, en teoría, suficiente, puesto que la capacidad del ser humano para percibir el sonido se sitúa en torno a los 120 db. Por encima de 120 db se encuentra el umbral del dolor.

Capacidad de registro del rango dinámico en función de la profundidad de bit. Fuente: Libremusicproduction.

En grabaciones de música clásica tiene mucho sentido utilizar 24 bits, ya que la diferencia de dinámica entre un Piano-Pianissimo y toda la orquestra tocando a la vez es muy grande.

En cine, también es muy importante el rango dinámico. En estudios de grabación de orquestas para bandas sonoras suelen preferir utilizar 32 bits para capturar más dinámica. Las excelentes condiciones de reproducción del sonido en una sala de exhibición permiten apreciar con claridad tanto los sonidos más leves como el estruendo de las escenas de acción.

Sin embargo, en radio o en televisión, se utilizan compresores para reducir el rango dinámico y el resultado es que no hay tanta diferencia entre los niveles de sonido más bajos y los más altos. Esta compresión dinámica se hace para aumentar la sonoridad (loudness) y ayudar a la inteligibilidad del sonido en condiciones críticas de audición, por ejemplo, al escuchar la radio en un coche o la televisión en un ambiente ruidoso. El resultado es que tanto los susurros como los gritos quedan a un nivel alto e inteligible. La víctima en este proceso es el rango dinámico y el resultado se aleja de la percepción natural del sonido.

Forma de onda de la señal sin comprimir (abajo) y con compresión dinámica (arriba). Fuente: Wachusett.

Esta cuestión se hace patente en la sensación de volumen que tiene la publicidad en televisión. Los radiodifusores se han dado cuenta de que las mediciones de los picos de sonido no reflejan la sensación de volumen de un programa. Los productores de los anuncios hacen las mezclas de sonido con mucha compresión dinámica, sacrificando el rango dinámico en favor de una mayor sonoridad. Esto genera quejas de los usuarios y baja los estándares de calidad de sonido:

“Todo suena super-plano, y se hace una guerra de decibelios para ver quien suena más fuerte” (Sergio Márquez)

La normativa europea EBU R 128 (2011) “Normalización de la sonoridad y nivel máximo permitido de las señales de audio” trata de poner orden en esta cuestión:

“The switch from audio peak-normalization to loudness normalization is probably the biggest revolution in professional audio of the last decades. It is important for broadcasters to be aware of the loudness paradigm and how to adopt their systems and working practices accordingly.” (Roger Miles, EBU)

WLM loudness meter. fuente: Waves

“Lo importante no es quien suena más fuerte, sino que la película que están poniendo en televisión suene parecida a cómo se escuchaba en la sala de cine, es decir, con sus picos altos y sus pasajes de susurros. Tenemos la tecnología suficiente para tratar 120 db de rango dinámico. ¡Pues olvidémonos de estar sonando todo el rato a 100 db en TV! Procuremos respetar una dinámica apropiada para cada entorno.” (Sergio Márquez)

“Si un compositor quiere transmitir ruido, agresividad, malestar, ira, etc.… parece buena idea hacer salvajadas con el sonido, pero si la razón es la de ‘es que no quiero sonar más bajo que los demás’, creo que es mejor que se vaya haciendo a la idea de que las reglas del juego han cambiado.” (Ibon Larruzea)

Códecs para sonido multicanal

Fantasía (1940, Walt Disney) es la primera película que experimentó con el sonido envolvente (surround sound) para cine. Desde entonces se han desarrollado muchos sistemas de sonido para mejorar la experiencia de usuario tanto en las salas de exhibición como en el hogar (home cinema).

Colocación de los altavoces en un sistema multicanal de sonido envolvente para una sala de exhibición de cine. Fuente: wikipedia

En la actualidad, para cinematografía nos podemos encontrar con distintas configuraciones para sonido envolvente:

- L.C.R. (left, center, right): añade un canal central al clásico formato estéreo de la industria musical. Una variante, ya en desuso, es LCRS que utiliza un único canal surround.

- Surround 5.1: añade dos canales laterales (surround left, surround right) y un canal de subgraves (subwoofer).

- Surround 7.1: añade al 5.1 dos canales traseros (rear left, rear rght).

- Sonido inmersivo, sonido 3D o sonido por objetos: es una nueva concepción del sonido envolvente que no está basada en el número de canales sino en el posicionamiento espacial de cada fuente de sonidos.

El sistema 7.1 dedica dos canales independientes para el sonido trasero izquierdo y derecho diferenciados de los canales laterales. Fuente: Tech Review

Los inicios del audio digital para cine

En los años previos a la proyección de cine digital (DCI) había tres sistemas de audio digital para salas de exhibición: Dolby, DTS y SDDS. Estos tres formatos solventaron las limitaciones técnicas para registrar, almacenar y procesar sonido digital; así como la sincronización del sonido digital con la proyección de película de 35 mm.

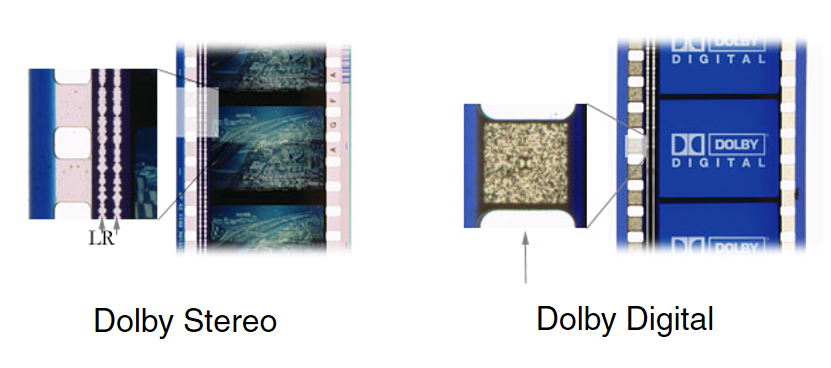

El primero en llegar en esta carrera fue ‘Dolby Digital (AC-3)’ que se estrenó en 1992 con Batman Returns (Tim Burton). Fue el primer sistema de audio multicanal digital 5.1 para cine. Era un códec con mucha pérdida de información, 10 a 1 (10:1), pero que discriminaba muy bien los sonidos más relevantes para el ser humano basado en su excelente codificación psicoacústica. Técnicamente era muy eficiente ya que lograba meter seis canales en 448 kb/s. Sin compresión, el equivalente serían casi 7 Mb/s.

La sincronización con la proyección se hacía imprimiendo las pistas de sonido en el celuloide. Esta técnica se llevaba usando desde los inicios del cine sonoro. En la siguiente imagen se puede ver la impresión de sonido analógico de ‘Dolby Stereo’, que se empezó a utilizar con Star War (1977, George Lucas), y la solución de Dolby Digital de los años 90 que empleaba el espacio de película entre las perforaciones para imprimir la señal de audio digital.

Impresión de las pistas de sonido en el celuloide: Dolby Stereo y Dolby Digital. fuente: Brian Florian

Justo después del lanzamiento de ‘Dolby Digital’, con Jurassic Park (1993, Steven Spilberg), apareció ’DTS Digital Theater System’ que daba más calidad y utilizaba mucha menos compresión (3:1). Este incremento de calidad gustaba sobre todo a los directores y al equipo técnico-artístico responsable de la banda sonora, pero era más complejo y costoso. DTS utilizaba un sistema propio para sincronizar el audio digital con la proyección de la película de 35 mm mediante un código de tiempo impreso en el celuloide y unos discos CD.

El tercer sistema, ’SDDS Sony Dynamic Digital Sound’, se lanzó con Last Action Hero (1993, John McTiernan) y estaba instalado sobre todo en las salas de exhibición que tenían acuerdos de distribución con Sony. Esta patente definió un primer sistema 7.1, que es distinto al que actualmente se utiliza: era una configuración de canales 7.1, ubicando detrás de la pantalla cinco de ellos (Left, Left-Center, Center, Right-Center y Right). Solo las grandes producciones de Hollywood mezclaban en este formato (principalmente Columbia Pictures, filial de Sony) que, además, al necesitar más altavoces y amplificadores era mucho más caro de instalar para el exhibidor.

De estas tres soluciones para el audio digital en salas de cine, Dolby, que llegó primero, consiguió convertirse prácticamente en el estándar de facto.

Años más tarde, cuando se sustituyeron los proyectores de película 35 mm por los sistemas digitales DCI, la sincronización del sonido dejó de ser un problema. El soporte de las películas pasó a ser un disco duro DCP con capacidad suficiente para almacenar y reproducir sonido sin compresión y se pudieron usar directamente los archivos en formato PCM (.wav) tanto para estéreo como para sonido envolvente 5.1 o 7.1.

A partir de entonces, para la proyección de cine digital, se puede hacer sonido multicanal sin pagar ningún tipo de licencia, ni royalties de patente alguna.

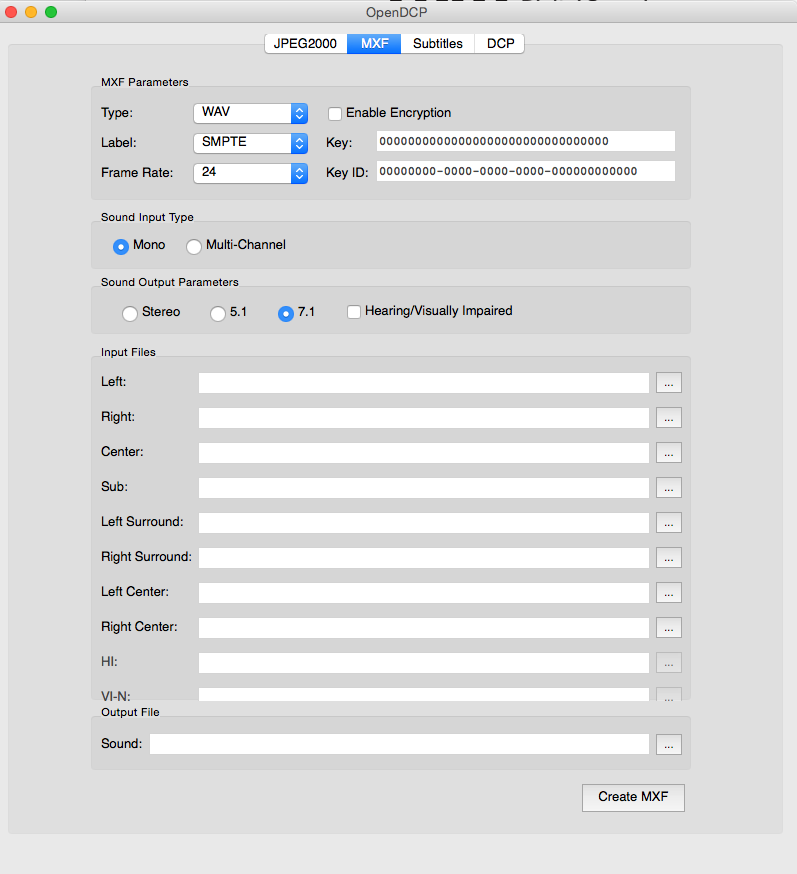

En la siguiente captura de pantalla se puede ver el menú del software ‘OpenDCP’ para la creación de un archivo de audio 7.1 para salas de cine: se parte de 8 canales mono en formato PCM (.wav) sin comprimir para generar un archivo MXF.

Configuración de los canales de sonido para 7.1 para DCP con OpenDCP. El sistema crea un archivo MXF a partir de los ocho canales mono en formato PCM (.wav)

Informe elaborado por Luis Ochoa, Sergio Márquez y Francisco Utray.