Noticias, Tutoriales

LUT, ASC CDL, IFF/ACES y demás siglas

El Color Management o Administración de Color es una de esas disciplinas o técnicas postproduccioneras que no se valoran hasta que llegan los consabidos “marrones”, con sus grandes dramas y soluciones heroicas.

El Color Management no es más que conseguir que el resultado final se vea más o menos como esperábamos. La primera premisa que tenemos que aceptar es que el proceso nunca será fiable al ciento por ciento. Se podrán conseguir aproximaciones con una gran fiabilidad, pero no con total fidelidad de color.

¿Y esto por qué es así? Pues porque en todo proceso de producción hay una mezcla de dispositivos cada uno de ellos trabajando en distintos espacios de color, e, incluso, en pequeñas variaciones del mismo espacio de color. Todo esto se une al hecho de que el resultado final se va a ver en otro medio con sus propias características colorimétricas y en entornos que, en muchos casos (TV, DVD, BluRay, etc…), van a escapar de nuestro control.

Las cámaras de vídeo, de cine, o DSLRs trabajan cada una con un sensor de su padre y de su madre, con códecs distintos que imponen sus propias restricciones a la reproducción del color, etc… En entornos de vídeo digital tradicional, estas cámaras suelen trabajar en YUV, y en espacio de color Rec709 en HD o 601 para resolución estándar, mientras la mayoría de los softwares de “postpro” trabajan en RGB en cualquiera de sus variantes (sRGB). En el caso de las cámaras de cine digital y las cámaras de vídeo más modernas, esto se complica más aún con maldades como usar curvas de gamma propias, curvas logarítmicas, de-bayering y otras zarandajas.

Así que, solamente en la fase de captación ya estamos “falseando” o traduciendo la información de color. Para evitar esto se han utilizado diferentes aproximaciones a lo largo de los últimos años.

LUT: Las LUTs (Look Up Tables), no son más que una “ñapa” para facilitar las conversiones de color, o cualquier otra operación con flujos de datos. Una LUT no es más que una tabla de valores, en la que se establecen unas correlaciones entre un valor de entrada y otro de salida, es decir, este valor en la imagen que entra va a ser este otro en la imagen que sale tras aplicarle la LUT.

En el entorno que nos ocupa, las LUTs más simples son sólo un fichero de texto ASCII que describe una corrección de color. Lógicamente, el número de valores y las cantidades que indiquen dependen de los parámetros de la imagen, como profundidad de color, cantidad de canales, etc…

Las LUTs se han utilizado y se siguen utilizando para todo tipo de operaciones de color en postproducción, tales como conversiones de espacios de color, calibración de monitores y proyectores, etc… Las LUTs se pueden aplicar en diferentes partes del proceso de producción y de forma permanente o temporal, es decir, se pueden utilizar para convertir el material o se pueden usar sólo para previsualizar como quedará el material en otro espacio de color o soporte. Los ejemplos más habituales son las LUTs para previsualizar material LOG (logarítmico) en un dispositivo LIN ( lineal), como un monitor informático, o para ver como quedaría el material filmado y así tener una cierta fiabilidad en la corrección de color.

Hay dos tipos de LUTs básicamente, las LUTs de 1 dimensión (LUT 1D) y las LUTs de tres dimensiones (LUT 3D). La diferencia es básicamente la exactitud en la transformación de color entre una y otra y la cantidad de colores que pueden describir. Las de tres dimensiones describen un cubo con cada uno de los colores primarios en un eje y todas las posibles variaciones como puntos dentro de ese cubo; son las más complejas y las que más se usan hoy en día.

¿Dónde y cómo se aplican las LUTs? Bueno esta es una pregunta con respuestas casi infinitas, porque hay muchas posibles variaciones del tema, dependiendo de cada workflow. Lo más habitual es aplicarlo en los softwares de edición, color, composición, o incluso 3D, que en muchos casos soportan la carga de LUTs. Dentro de ellos los hay que permiten aplicarlo como una transformación permanente y/o sólo en previsualización, dejando el material original sin tocar.

Otra opción es usar dispositivos hardware que puedan cargar LUTs y aplicarlas a una señal de vídeo como el Blackmagic HDLink (http://www.blackmagic-design.com/products/hdlink/), el Davio de Cinetal (http://www.cine-tal.com/) o el Fig de TCube (http://www.tcube.tv/products/fig), entre otros.

Las LUTs son la base de los sistemas CMS (Color Managent Systems), que permiten medir la respuesta de colorimetría de todos o casi todos los dispositivos involucrados en nuestro workflow y generar LUTs o perfiles ICC que se apliquen para calibrarlos, compensar cambios de espacio de color o simplemente imitar el aspecto del color en el máster final en cine en soporte fotoquímico, vídeo, cine digital DCP, etc…

Como dijimos antes, las LUTs más simples son ficheros de texto, pero, cada fabricante ha implementado su manera de describir esas tablas de texto y por ello hay múltiples formatos de LUT, tanto 1D como 3D. La conversión en muchos casos no es muy compleja entre formatos, pudiendo llegar a hacerse manualmente con un viejo conocido, el Microsoft Excel, y un poco de maña.

No obstante, hay fabricantes que generan LUTs binarias e incluso encriptadas, así que os podeis encontrar con problemas al intentar abrirlas; una LUT bien calculada es un importante activo para una empresa que dependa del color, como un estudio de corrección de color o un laboratorio, y por tanto es normal que se guarden como un tesoro, y se limite mucho el acceso a la información que contienen.

Hay mucha documentación sobre el tema, pero podeis empezar aquí:

http://en.wikipedia.org/wiki/3D_LUT

Esta falta de estándares, las limitaciones de las LUTs y los problemas que todo esto genera ha llevado a la creación de dos iniciativas distintas:

ASC CDL: No es un sistema para la administración de color “per se”, pero si está muy relacionado con ella, porque es un estándar que permite llevar datos de corrección de color primaria desde el rodaje a todos los estadios del proceso de postproducción.

El nombre CDL significa Color Decisión List, o Lista de Decisiones de Color. A los que vengais de edición esto os sonará, es algo parecido a una EDL de toda la vida, pero con información de corrección de color. La creó la ASC (American Society of Cinematographers, el sindicato de los directores de fotografía americanos, vamos) en un intento por unificar una manera de pasar información de correcciones de color entre diferentes sistemas de diferentes fabricantes y entre el rodaje y la postpro.

La CDL usa 3 parámetros básicos, Slope, Offset y Power, correspondientes a las luces bajas, medias y altas, para cada uno de los tres colores primarios, lo que da un total de 9 valores para describir la corrección. Posteriormente se hizo una revisión 1.2 que añadía un decimo valor, la Saturación combinada de los tres colores primarios.

Todo esto se guarda como un fichero XML que contiene además información sobre las imágenes a las que se ha aplicado la corrección, tipo de señal, dispositivos de visualización, etc… Teóricamente, toda esta información es fácilmente traducible a los parámetros propios de cada software de corrección de color, edición, CMS, etc..

A día de hoy lo soportan varios softwares de Autodesk, Avid, Nucoda, Mistika, DaVinci, Filmlight, etc…

Para más información podeis mirar la entrada en Wikipedia o consultar la página de la ASC(si teneis suerte y os funcionan sus presentaciones :))

http://en.wikipedia.org/wiki/Color_Decision_List

http://www.theasc.com/clubhouse/ASC_CDL_Flash_Presentation.html

Esto nos lleva al recién nacido, el IIF ACES:

IIF ACES: Es un intento de unificar y estandarizar en un solo espacio de color todos los usados en la industria, desde la adquisición hasta el visionado final, pasando por todos los procesos intermedios de postproducción. Es decir, se trata de intentar que se use el mismo espacio de color desde la cámara hasta la proyección o generación del máster.

¿Quién crea esta norma? La Academia de las Artes y las Ciencias Cinematográficas ( AMPAS), es decir la misma Academia que da los premios Oscar; se le supone algún poder de decisión en la industria :). Como veis en el nombre, tiene una rama científica, el Comité de Ciencia y Tecnología, que es el que impulsó esta nueva norma de codificación de color y workflow para preservar la máxima información de color disponible en el rodaje.

Si os habeis fijado en estas siglas, consta de dos partes, la primera es IIF o Image Interchange Format (Formato de Intercambio de Imágenes). IIF no es más que el formato de fichero que se ha propuesto para llevar la información de imagen a lo largo de todo el proceso de producción y postproducción; se quiere que sea el sustituto de los DPX.

El formato IIF está basado en el OpenEXR de ILM, que es un archivo de código abierto que permite llevar información de color de alto rango dinámico (Half-Float a 16 bits por canal en este caso) y múltiples canales de información en un único fichero.

Open EXR (o EXR para los amigos) es “de facto” un estándar en la composición digital de efectos visuales y 3D y, lo mejor, es un formato de código abierto, muy ampliable y personalizable, de forma que se ha elegido hacer una versión restringida de EXR para contener la información que especifica ACES. Así IIF llevará la información propiamente de imagen, codificada según ACES, más información de metadata. Otra ventaja de usar EXR es que es muy fácil la implementación de IIF en softwares y sistemas que ya soportan EXR.

Para más información sobre OpenEXR podeis consultar esto:

http://en.wikipedia.org/wiki/OpenEXR

También tengo intención de hacer un artículo sobre OpenEXR y otras iniciativas Open Source de la industria muy especializadas en un futuro próximo.

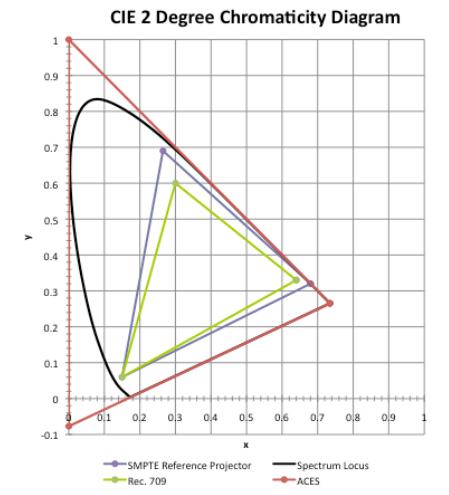

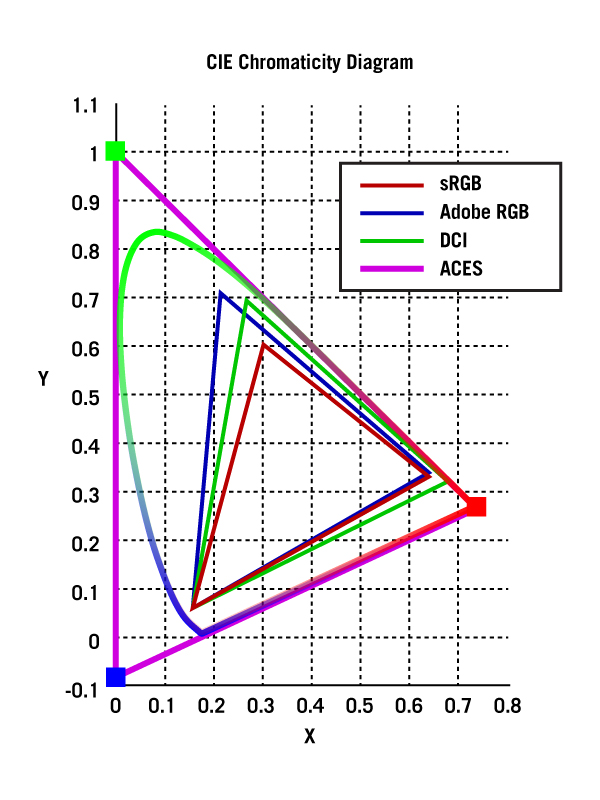

Las otras siglas, ACES, significan Academy Color Encoding Specification o Especificación de Codificación de Color de la Academia. Los ficheros IIF contienen información en un espacio de color propio llamado ACES, que contiene una cantidad de información de color mucho mayor que los espacios de color actualmente existentes (principalmente sRGB con codificación Lineal o Logarítmica y rec709 de vídeo HD).

¿Cómo es este espacio de color? Lo primero y más importante, es Lineal, según la especificación es Scene Linear, es decir se supone que los valores de los píxeles tienen una correlación lineal con respecto a la información de color que llega al sensor, al contrario que las codificaciones logarítmicas que usan muchas cámaras, que no son más que una manera de conseguir la mayor información de color con la mínima profundidad de bits, pero alterando los colores en la imagen de alguna forma. Esto es lo contrario al modelo actual en el que se convierte a un espacio de color que viene fijado por el dispositivo de visionado (como el rec709 de HD para visionar en monitores HD), ya que se supone que sus limitaciones son las que nos van a marcar hasta donde podemos manipular la imagen.

Como ya hemos dicho antes, la información se guarda a 16 bits por canal, en Half-float, es decir, los posibles valores para cada uno de los canales varían entre -65.504 y +65.504. Todo esto supone un espacio de color enorme, con un rango dinámico tremendamente grande, mucho mayor que lo que permiten los espacios de color actuales, la documentación habla de un rango de más de 25 stops, capaz de cubrir todos los colores percibibles.

¿Qué no es? Una imagen codificada según ACES no es una imagen RAW, es decir para codificarlo en ACES la imagen RAW debe ser “de-bayerizada” (toma palabro) y convertida al espacio de color de ACES. La ventaja es que, este espacio de color es prácticamente infinito (en términos de color) y por lo tanto seguiremos teniendo información para manipular la imagen sin la aparición de problemas o artefactos.

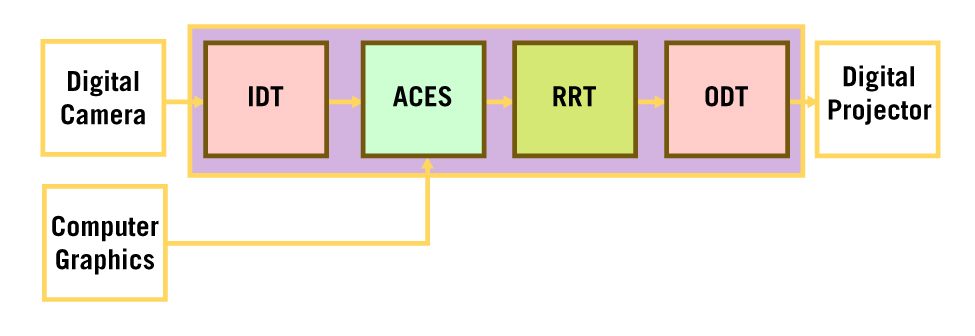

¿Cómo se aplica esto a un workflow real? Bueno, partamos de un workflow habitual hoy en día, se hace la captación con una cámara digital, luego se edita offline, se conforma, se integran los efectos y se corrige el color, todo en digital, con vistas a generar un máster final para exhibición digital y fotoquímica.

En un caso como este se aplicaría una transformación o IDT al material grabado, esta IDT no es más que una transformación de espacio de color del material de cámara, usando una transformación (similar a una LUT) específica para cada cámara y que convierte ese material en una imagen en espacio de color ACES. Es decir, se crea una imagen que se supone que será coherente con cualquier otra tomada por cualquier otra cámara en las mismas condiciones.

Esto significa que se pueden eliminar muchos de los problemas y dolores de cabeza actuales producto de trabajar con diferentes cámaras en el mismo proyecto, ya que, las imágenes en ACES estarán codificadas teniendo en cuenta las características de cada cámara; se aplica una curva específica para cada cámara, que nos dará cómo resultado una imagen en un espacio de color estandarizado.

Además, los software que generan material por ordenador (CGI, principalmente el 3D) pueden fácilmente generar sus imágenes en este espacio de color para su posterior integración con el material de rodaje.

La otra ventaja es trabajar en un espacio de color prácticamente ilimitado, con lo que los procesos de corrección son mucho menos susceptibles a presentar degradaciones o limitaciones debidas a la codificación del color.

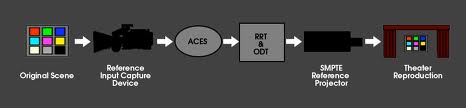

La siguiente parte del proceso es la visualización y la generación de másters finales, para ello se usan dos nuevas transformaciones,la RRT y la ODT.

La RRT o Reference Rendering Transform no es más que otra transformación que convierte la imagen en una imagen ideal que es la base para todas las imágenes que vamos a ver en los diferentes medios de visualización.

Posteriormente esta imagen RRT es transformada por otra transformación que ya es especíca de cada medio de visualización o mastering,la ODT o Output Device Transform. Es decir, de forma análoga a como se hizo en cámara, ahora aplicamos una transformación para cada monitor, proyector, etc… que asegura una gran coherencia de color entre los diferentes medios usados para visionar el material.

También se designa otra transformación, similar al ODT, pero específica para los proyectores de Cine Digital,la RDT o Reference Device Transform.

En el caso de material fotoquímico la norma propone también un proceso análogo a la IDT para llevar la información de densidad del negativo al fichero digital en espacio de color ACES, la ADX o Academic Density eXchange, que sería específica para cada escáner o bien escáners que soportaran el estándar APD de calibración.

¿Pero esto es real o es sólo una “ida de olla” más de los americanos? Pues si, es tan real que todos o casi todos los fabricantes de cámaras, softwares de color y demás ya se han apresurado a sacar sistemas o revisiones que son “ACES compliant”, es decir, que cumplen o permiten seguir un proceso de producción con codificación o espacio de color ACES. Así, por ejemplo, la nueva Sony F65 ya soporta este estándar y varios softwares como Nuke o RedCineX, o sistemas para rodaje como Codex o Cinedeck ya soportan o han anunciado el soporte de IIF ACES.

Podeis ver más aquí:

http://pro.sony.com/bbsccms/assets/files/show/highend/includes/F65_Camera_CinemaPDF.pdf

http://www.cinedeck.com/#!subpage/the-ghost-of-goodnight-lane

Además, ya se está llevando a la práctica en algunas series americanas, como la serie “Justified” de FX (totalmente recomendable, por otro lado), cuya segunda temporada ya se hizo siguiendo las especificaciones de IIF ACES. Más info aquí:

http://www.studiodaily.com/2011/02/is-justifieds-new-workflow-the-future-of-cinematography/

Otra de las implicaciones de este estándar es la adopción de un formato de archivo estandarizado para material audiovisual, e incluso ya se está discutiendo con la SMPTE sobre ello. No obstante, conviene recordar que todo este estándar está aún desarrollándose, y para su implantación va a precisar de un acuerdo entre fabricantes de cámaras, softwares, sistemas de grabación, archivo, etc…

Dos muy buenos artículos sobre IIF ACES:

http://www.fxguide.com/featured/the-art-of-digital-color/

Y más info y un PDF de la propia AMPAS:

http://www.oscars.org/science-technology/council/projects/iif.html

http://www.oscars.org/science-technology/council/projects/pdf/iif.pdf

IMPRESIONANTE artículo, super util!

Como dicen por el comentario de arriba…

Muy bueno y completo si señor.

Ya que mencionais IIF-ACES no estaría de más mencionar OpenColor IO

http://opencolorio.org

No os adelanteis, tengo pensado otro post sobre OCIO, Ramen, y otras marcianadas varias.. será un post sobre los softs open source que los grandes estudios de post y VFX han ido liberando por ahí.

De todas formas, como siempre cualquier aporte es bienvenido….

Diles a los de TheFoundry que OCIO es una marcianada que han puesto en Nuke :p

¿Decírselo? Si yo no tengo nada que ver con The Foundry. Además, OCIO es un desarrollo de Sony Imageworks que es open source y, en tanto es un CMS bueno, bonito y de gratis, no creo que haya mucho por lo que quejarse. Además, te vale para generar perfiles ICC, LUTs y demás, cuando las alternativas comerciales (Truelight, CineSpace, LighSpace y demás) valen un pastón…

Increíble artículo. Muy completo. Gracias por compartir.

Os adjunto link a Kevin Shaw que ha escrito un artículo sobre Aces bastante completo también

http://www.finalcolor.com/acrobat/ACES_Nucoda%20r2_web.pdf

Abrazos alberos!

Wonderfuloso, información interesante a manos llenas!

Me ha gustado mucho el artículo. Gracias.

David, ¿se puede visualizar el espacio ACES en un monitor «normal» sRGB o hace falta uno que soporte este espacio como si del XYZ se tratara? ¿Cómo se lleva a cabo la RRT y ODT caso de que sean necesarias para esta monitorización? ¿es por software? muchas gracias!

excelente y muy claro su artículo, gracias